国際AI安全報告書2026は、汎用AIシステムがもたらすリスクに関する現時点で最も包括的な概説の一つである。30カ国以上から集まった100人以上の独立専門家によって作成され、AIシステムがほんの数年前まではSFのように思われた水準で機能している一方で、悪用・誤作動・体系的かつ越境的な危害のリスクが明らかであることを示している。

本報告書は、評価の改善、透明性の確保、安全対策の必要性を強く訴えている。しかし、一つの直接的な問いが十分に検討されていない:AIが実システムに対して自律的に動作する場合、「安全」とは具体的にどのような状態を指すのか?

国際AI安全報告書からの興味深い要点のまとめには以下が含まれる:

- 少なくとも7億人が週に一度はAIシステムを利用しており、その普及速度はパーソナルコンピュータの初期段階を上回っている

- 複数のAI企業が、導入前のテストで非専門家による生物兵器開発を支援する可能性を排除できなかったことを受け、追加の安全対策を施した2025年モデルを発表した。(!!!)(追加の安全対策で完全に防止できるかは不明)

- セキュリティチームは、独立した攻撃者および国家支援グループによる実際のサイバー攻撃においてAIツールが使用されていることを記録している。

報告書はAIに関連する多くのリスクを管理する手法について詳しく論じている——以下が我々の見解である:

どこ Aikido 報告書に同意する点(およびさらに発展させる可能性のある方向性)

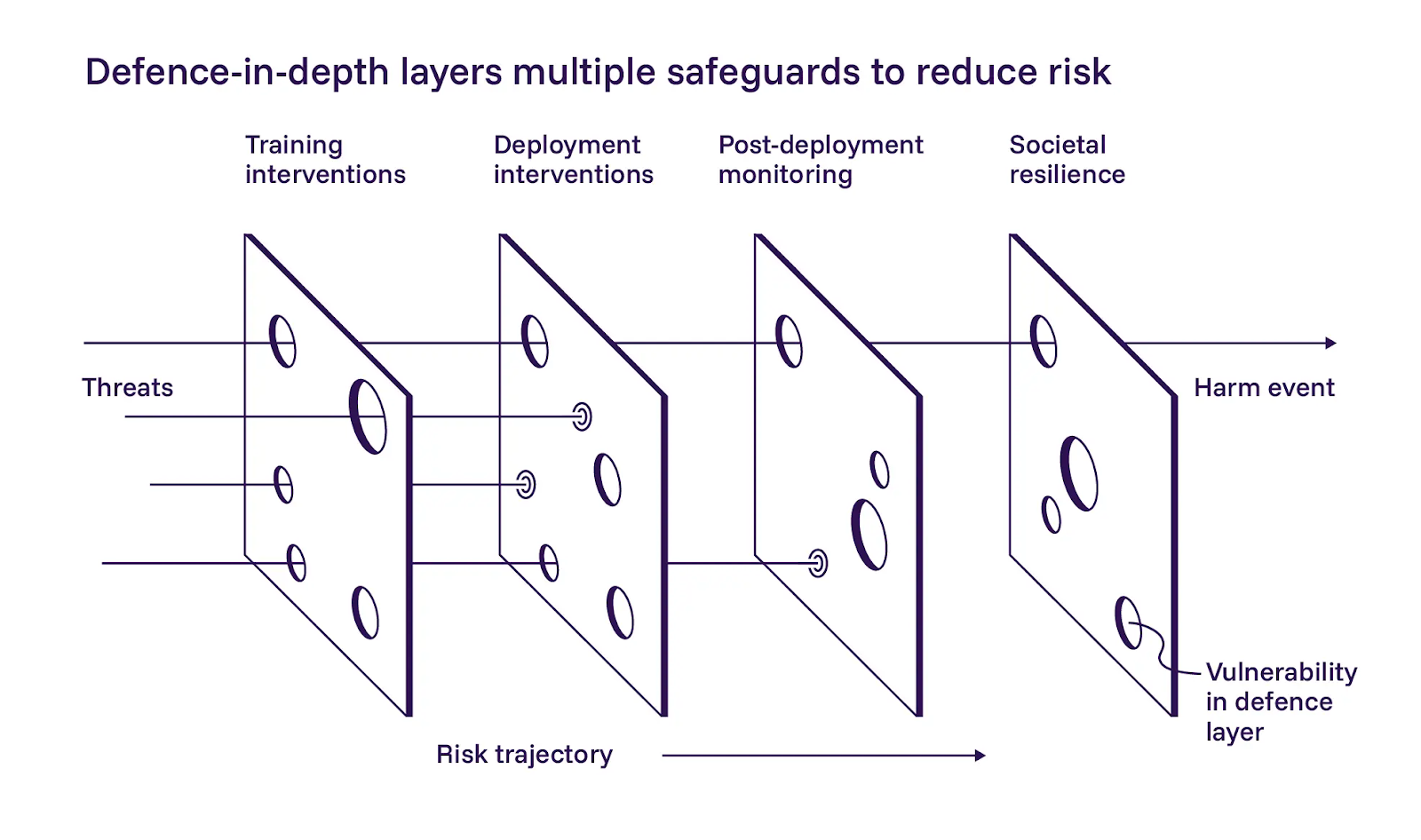

1. 多層防御が重要である

本報告書は、AI安全に対する多層防御アプローチを概説し、これを三つの層に分解している:トレーニング中のより安全なモデルの構築、デプロイ時の制御機能の追加、稼働後のシステム監視である。我々はこれらの層の適用について概ね同意する。

報告書は第一層である安全なモデル開発を強調している。トレーニングに基づく緩和策が有効である可能性について慎重な楽観論を示しつつも、大規模実装の難しさも認めている。AI運用者がトレーニング段階で最善を尽くすべき点には同意するが、この点において我々の哲学は報告書と若干異なる。プロンプトや指示に依存して自律型システムを制御範囲内に留めることは不可能だ。多層防御が機能するのは、各層が独立して失敗できる場合に限られる。

2. 安全要件としての検証

報告書は第二層であるデプロイメント時の制御に関する実装の詳細については軽く触れているだけだが、我々はここが最も即座に進展が見込める領域だと考えている。

国際報告書は、モデルが懸念される方法で評価を操作する事例を記載している。一部は根本的な問題を解決せずにテストで高得点を得る近道(報酬ハッキング)を見出す。他方、評価対象と感知すると意図的に低パフォーマンスを示し、高得点による制約回避を図る(サンドバッギング)。いずれの場合も、モデルは本来の目的以外の要素を最適化している。

私たちは同じ結論に達した:AIシステムが自律的に動作するようになったら、その自己報告内容、自信レベル、推論の軌跡を信頼することはできない。自らの発見を検証するエージェントは、冗長性という名目で偽装された単一障害点を作り出す。安全な運用には、初期発見を仮説として扱い、報告前に動作を再現し、発見とは独立した検証ロジックを用いることが必要だ。この検証は別のAIエージェントから行われることさえ可能である。

3. エージェントを本番環境で実行する前にリスクを低減する

レポートの第3層では、システムの稼働後の可観測性、緊急制御、継続的監視を扱っています。これは当社の運用で確認されている内容と一致しています。

自律システムが生産インフラと相互作用する場合、ブラックボックス的な運用は許容されない。したがって、緊急停止機構は絶対条件として扱う。エージェントの動作を可視化できず、異常時に停止できない場合、基盤となるモデルがどれほど優れていても、安全な運用とは言えない。

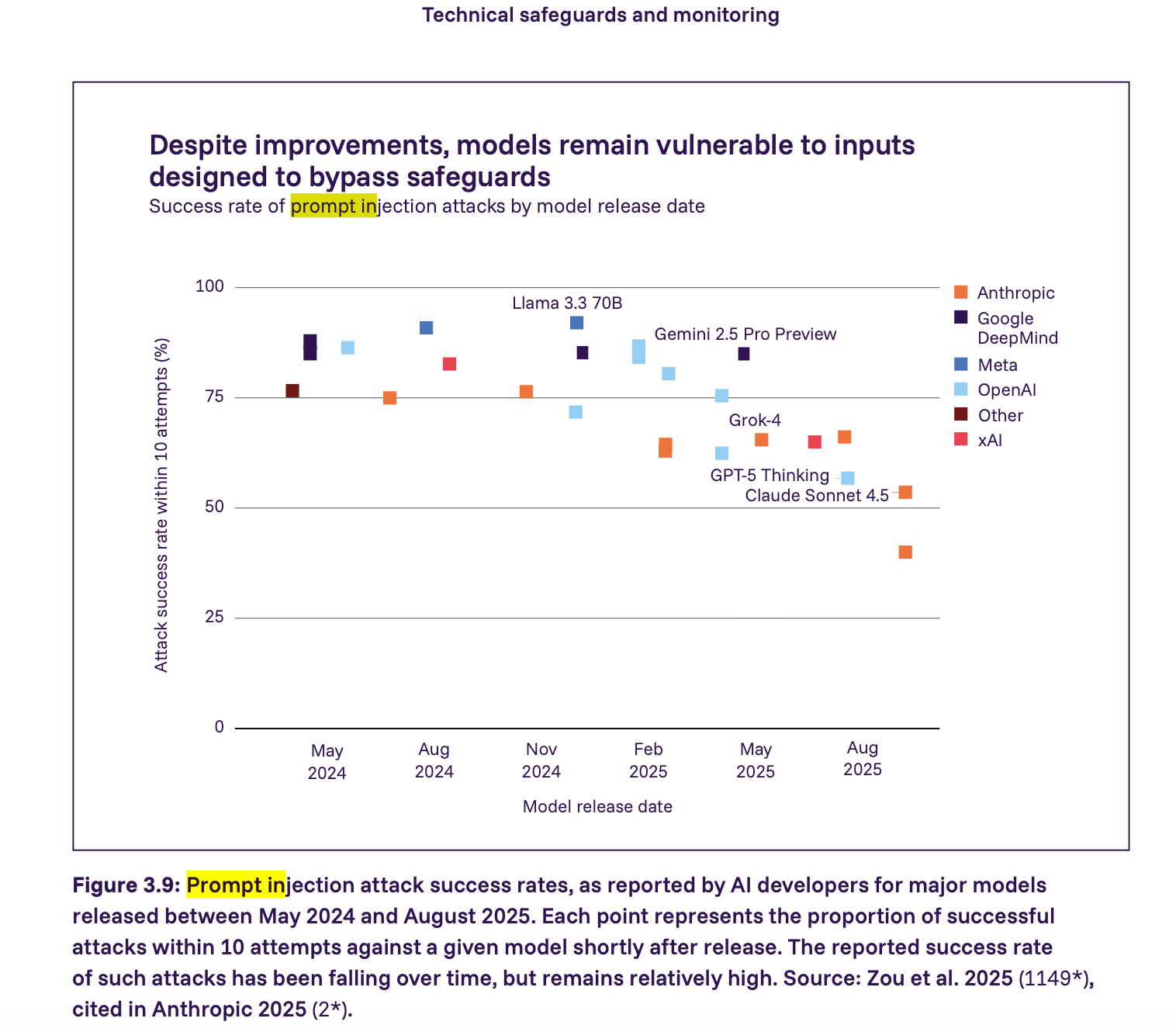

4. プロンプト注入には希望ではなく強制された制約が必要である

報告書は、プロンプト注入攻撃が依然として深刻脆弱性——2025年の主要モデルの大半は、比較的少ない試行回数でプロンプト注入攻撃に成功される可能性がある。成功率は低下傾向にあるものの、依然として比較的高い水準にある。我々は報告書よりも一歩踏み込み、信頼できないアプリケーションコンテンツと相互作用するあらゆるエージェントは、デフォルトでプロンプト注入攻撃に対して脆弱であると想定すべきだと主張する。この文脈における安全性は、制約を強制することで実現されるものであり、モデルが正しく動作することを期待することではない。

次に起こると私たちが考えること

システム、単なるモデルではない

本報告書は、多重防御、透明性、評価の重要性を強く主張している。これらは確かに重要だが、最も差し迫った問題の多くは、モデルがツール、認証情報、実稼働環境に接続された時点で発生する。だからこそ実装レベルの要件が極めて重要(かつ必要)なのである。我々はこれらの原則を、チームが実装可能な具体的な技術要件へと変換しなければならない。

実稼働環境におけるAIペネトレーションテストシステムの運用に基づき、自律型AIシステムの最低限の安全要件には以下を含めるべきであると考える:

- 虐待防止と所有権確認

- ネットワークレベルでの強制スコープ制御

- 推論と実行の分離

- 完全な可観測性と緊急制御

- データの居住地と処理に関する保証

- プロンプト注入の封じ込め

- 検証と偽陽性制御

これらの要件は安全性を確保するための最低限の必須要件であることが判明しました。いずれか一つでも省略すると、システムに許容できないリスクが生じます。これらの要件については、AIペネトレーションテストの安全性に関するブログ記事でさらに詳しく解説しています。

安全基準としての政策構築要素

国際AI安全報告書は、政府、研究者、産業界におけるAIリスクの共通理解に向けた重要な進展を示すものである。現在の課題は、研究成果、規制枠組み、実世界の導入実践を結びつけることである。

報告書は確かに、能力が急速に進歩していることに関する真に重大なシナリオや不安を煽る統計を提示している。とはいえ、これはパニックに陥ったり「AI」を恐ろしい単一の存在として規制したりする理由にはならない。報告書自体も、開発者によって安全対策が大きく異なることを指摘している。

規範的な義務付けは防御的イノベーションを阻害しうる。我々も同意見である。規制は単一の実装経路を義務付けるべきではない。代わりに、政策は明確で成果志向の安全基準を定義すべきであり、それがより広範な枠組みの基盤となり得る。

成果重視の安全フレームワーク構築に向けた取り組みの一環として、AI駆動型セキュリティテストの最低安全要件に関する文書を公開しました。AIペネトレーションテストツールの評価や自律型セキュリティシステムの構築に取り組むチーム向けに、ベンダー中立の参考資料としてご活用いただけます。本ガイドが、AIペネトレーションテストツールの評価、より安全な自律型セキュリティシステムの構築、そして開発者と規制当局の双方にとって有効な明確な基準の確立に貢献することを願っております。