実際のシステムに対してAIペネトレーションテストを安全に実行できるのはいつなのか?

ペネトレーションテストに不安を感じるなら、時代遅れではありません。むしろ時代の先を行っているのです。

セキュリティテストは、AIがもはや人間を補助するだけでなく自律的に行動する最初の領域の一つである。現代のAIペネトレーションテストシステムは、アプリケーションを自律的に探索し、実際のアクションを実行し、観察した内容に基づいて適応する。

それは強力だ。同時に、制御、安全性、信頼性について非常に現実的な疑問も提起する。

この投稿は、AIペネトレーションテストが機能するか否かについてではありません。実際に安全に実行できるタイミングについてです。

AIペネトレーションテストに対する懐疑的な見方が合理的である理由

私たちが話を聞くセキュリティ責任者のほとんどは、AIに反対しているわけではありません。彼らは慎重であり、それには正当な理由があります。

彼らは次のようなことを心配している:

- テスト対象に対する制御を失う

- エージェントが意図せず生産システムと相互作用する

- ノイズ 真の問題ノイズ

- 機密データが不明確な方法で取り扱われている

- 内部の動作を説明できないブラックボックスのように振る舞うツール

それらの懸念は正当なものであり、特に今日「AIペネトレーションテスト」と称されるものの多くが、この分野への信頼構築に寄与していないことが理由である。

一部のツールDAST 。他のツールはチェックリストベースのシステムで、エージェントが次々と問題をテストします。どちらのアプローチにも限界があり、システムが自律的に動作する状況に備えることはできません。

True AIペネトレーションテスト 異なるペネトレーションテスト 、その違いが安全基準を変える。

真のAIペネトレーペネトレーションテストテストで変わるもの

スキャナーや指示に従うツールとは異なり、真のAIペネトレーションペネトレーションテスト :

- 自律的に決定する

- 実際のツールとコマンドを実行する

- ライブアプリケーションやAPIと連携する

- フィードバックに基づいて行動を適応させる

- 多くのエージェントを並列に実行して大規模に稼働させる場合が多い

このレベルの自律性に達すると、意図や指示だけでは不十分となる。システムが予期せぬ挙動を示した場合でも、安全性は技術的に強制されなければならない。

それは単純な疑問につながる。

「安全な」AIペネトレーションテストには実際に何が必要なのか?

実際の運用におけるAIペネトレーションテストシステムの運用に基づき、明確な基準が浮かび上がってきている。これらは、AIペネトレーションテストを安全に実行できると考える前に存在すべき要件であると我々は考えている。

このリストは意図的に具体的です。各要件は、検証、実施、監査が可能な事項を記述しており、原則やベストプラクティスではありません。

1. 所有権の検証と不正利用の防止

AIペネトレーションテストシステムは、オペレーターが所有する資産、または明示的にテストが許可されている資産に対してのみ使用可能でなければならない。

少なくとも:

- テスト開始前に所有権の確認が必要です

- 認証は技術的に実施されなければならず、ユーザーによる宣言を通じてはならない

これがなければ、AIペネトレーションテストプラットフォームは単なる攻撃ツールに成り下がる。安全性は最初のリクエストが送信される前から始まっている。

2. ネットワークレベルでのスコープ強制

エージェントは最終的にドリフトします。これは想定される動作であり、バグではありません。

そのため:

- すべての送信リクエストはプログラムによって検査されなければならない

- ターゲットは明示的に許可リストに登録されなければならない

- デフォルトでは、すべての非承認の宛先をブロックする必要があります

スコープの強制はプロンプトや指示に依存してはならない。ネットワークレベルで、すべてのリクエストに対して行われる必要がある。

例:

- ステージング環境のテストを指示されたエージェントは、本番環境へのリンクを誤って追跡しようとする場合があります。ネットワークによる強制がない場合、その誤りは対象に到達します。強制がある場合、リクエストはシステム外に出る前にブロックされます。

3. 推論と実行の分離

エージェント型ペネトレーションテストシステムは、bashコマンドやPythonスクリプトなどの実際のツールを実行します。これにより実行リスクが生じます。

最低限の安全要件には以下が含まれます:

- エージェント推論とツール実行の厳密な分離

- サンドボックス化された実行環境

- エージェント間および顧客間の分離

エージェントが不正行為を行ったり操作されたりした場合でも、実行は完全に封じ込められた状態を維持しなければならない。

例:

- 初期のコマンド実行試行は成功したように見えるが、実際にはローカルで実行される。検証と隔離により、これらの結果が誤って解釈されたり、サンドボックスを超えてエスカレートしたりすることを防ぐ。

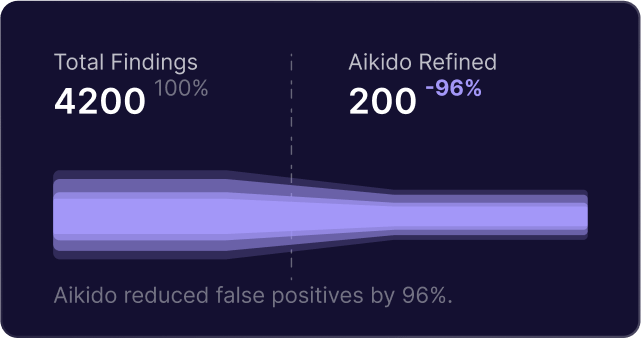

4. 検証と偽陽性制御

自律システムは誤った仮説を生成する。それは予想されることである。

安全なシステムは次の条件を満たさなければならない:

- 初期の発見を仮説として扱う

- 報告前に動作を再現する

- 発見ロジックとは独立した検証ロジックを使用する

これがなければ、エンジニアはノイズ に圧倒されノイズ 真の問題が見落とされてしまう。

例:

- エージェントは応答遅延を理由に潜在的なSQLインジェクションをフラグ付けする。検証ステップでは異なるペイロードでリクエストを再実行し、遅延が一定にスケールしない場合に検出結果を却下する。

5. 完全な可観測性と緊急制御

AIペネトレーションテストはブラックボックスであってはならない。

オペレーターは以下の能力を有している必要がある:

- エージェントが行ったすべてのアクションを検査する

- リアルタイムで行動を監視する

- 何かおかしいと思ったら、直ちにすべての活動を停止してください

緊急停止機構は、高度な機能ではなく、基本的な安全要件である。

6. データの居住地と処理に関する保証

AIペネトレーションテストシステムは機密性の高いアプリケーションデータを扱います。

最低限の要件には以下が含まれます:

- データの処理および保存場所に関する明確な保証

- 必要に応じた地域的な隔離

- デフォルトではクロスリージョンデータ移動は行われません

これがなければ、技術的能力にかかわらず、多くの組織はAIペネトレーションテストを導入できない。

7. プロンプト注入の封じ込め

エージェントは設計上、信頼できないアプリケーションコンテンツとやり取りします。プロンプトの注入は想定されるべきです。

安全なシステムは次のことを満たさなければならない:

- 管理されていない外部データソースへのアクセスを制限する

- データ漏洩経路を防止する

- 実行環境を分離し、注入された命令がスコープ外に漏れないようにする

プロンプトインジェクションは特殊なケースではない。脅威モデルの一部である。

これが約束することとしないこと

自律システムは、人間と同様に、いくつかの問題を見逃すことがある。

目標は完璧さを追求することではない。目標は、既存の特定時点でのテストモデルよりも迅速に、より安全に、そしてより大規模に、実質的に活用可能なリスクを可視化することである。

安全基準を公表した理由

私たちはセキュリティチームと何度も同じ会話を繰り返していた。

彼らが求めていたのは、より多くのAIではなかった。システムを安全に稼働させられるかどうかを評価する方法を求めていたのだ。

共通の基盤が確立されるまでは、チームはAIペネトレーションテストツールが責任を持って動作しているのか、それとも単に安全を前提としているのかを推測するしかない。

そこで私たちは、最低限の基準となるものを書き出しました。製品のチェックリストでも比較表でもありません。チームがツールを評価し、より良い質問をするために活用できる、実行可能な要件のセットです。

安全基準全文を読む

このリストの簡潔でベンダー中立なバージョンを社内で共有したり、ツール評価時に使用したい場合は、PDFとして公開しています。

また、付録として、ある実装例である合気道がどのように示されているかも含まれている。 Aikido 攻撃がこれらの透明性要件にどのように対応するかを示す付録も含まれています。

こちらでご覧ください:AIペネトレーションテストはいつ安全か?自律型セキュリティテストの最低限の安全要件

実際の動作を確認する

これらの安全要件が実際のAIペネトレーションテストシステムでどのように実装されているか気になる方は、当社のAI駆動型セキュリティテスト手法である「Aikido 」もご覧ください。

これは、AIペネトレーションテストシステムが実アプリケーションに対して大規模に運用される際に必要となる要件に基づき、これらの制約を満たすために構築された。

その仕組みを探ることもできますし、検討中のツールを評価するためにこのリストを活用することもできます。

今すぐソフトウェアを保護します。